Mc-pseudo 라벨링 방식을 활용한 화재 데이터 자동 생성에 관한 연구

초록

현재 데이터 증강 분야가 지속적 발전을 하고 있으나 초기에 적은 학습 데이터로 인하여 편향된 바이어스가 학습에 악영향을 주는 것을 개선하기 위한 연구는 적어 보인다. 본 논문에서는 가짜(Pseudo) 라벨링 시 초기에 편향된 라벨링으로 인하여 화재 오인식 및 데이터 증강에 악영향을 주므로 이를 개선하기 위하여 Mc-pseudo 라벨링 방식을 도입하였다. Mc-pseudo 라벨링 방식은 초기에 라벨링 한 가짜 라벨링에도 잘못된 정보로 학습할 수 있다고 가정을 하고 몬테카를로 드롭아웃을 활용하여 라벨링의 불확실성 분포를 예측하고 불확실성(Uncertainty)이 높은 특정 라벨링에 대해서는 라벨링을 보류하거나 변경하는 방식으로 학습의 정확도를 개선하였다. 그 결과 실제 사람이 손으로 라벨링 한 데이터와 비교 시 loss는 약 1.7%, mIOU는 9.09% 개선되었으며, mAP@50은 약 8% 개선된 결과를 얻었다.

Abstract

Although the field of data augmentation is currently making continuous progress, there appears to be little research to improve the negative impact of bias on learning due to small initial training data. In this paper, the Mc-pseudo labeling method was introduced to improve fire misrecognition and adversely affect data augmentation due to initially balanced labeling during pseudo labeling. The Mc-pseudo labeling method assumes that even initially labeled pseudo labeling can be learned with incorrect information, uses MC-dropout to predict the distribution of labeling uncertainty, and withholds or changes labeling for specific labeling with high uncertainty. The accuracy of learning was improved through this method. As a result, when compared to actual human-labeled data, loss was improved by about 1.7%, mIOU was improved by 9.09%, and mAP@50 was improved by about 8%.

Keywords:

convolution neural network, semi-supervised learning, self-training, deep learningⅠ. 서 론

현재 컴퓨터 비전 분야에서 데이터 생성을 위해서 주로 사용하는 방식이 준지도 학습(Semi-supervised learning) 방식과 자기지도 학습(Self-supervised learning) 방식이다. 준지도 학습은 라벨링 된 정답 데이터가 충분하지 않을 때, 레이블이 없는(Unlabeled) 데이터도 함께 이용하여 모델을 학습시키는 방법이다. 적은 양의 labeled 데이터로 지도 학습(Supervised learning)을 한 후, 학습 모델로 unlabeled 데이터의 정답 라벨을 예측하게 하는 방식이다. 이렇게 예측한 라벨을 가짜라벨(Pseudo label)이라 한다. 다음 단계 학습 시에는 모든 데이터셋을 정답 labeled 데이터로 간주하고 사용하는 방법이다[1].

자기지도 학습은 unlabeled 데이터를 이용해 모델 스스로 레이블링 하는 것이다. 입력 데이터의 한 부분이 다른 부분의 감독이 되게 하는 것이다. 입력에 대한 레이블 없이 입력 그 자체만으로 만든 라벨에 대해 구분 가능하게 훈련해 데이터의 labeled 데이터를 얻는 방법이다[2]. 자기 학습(Self-training)은 준지도 학습 방법론과 자기지도 학습 방법론을 적당히 아우르는 말이다. teacher-student 방식으로 선 학습된 가중치 값을 재사용하는 과정이 있으면 자기 학습 방법이라 한다[3].

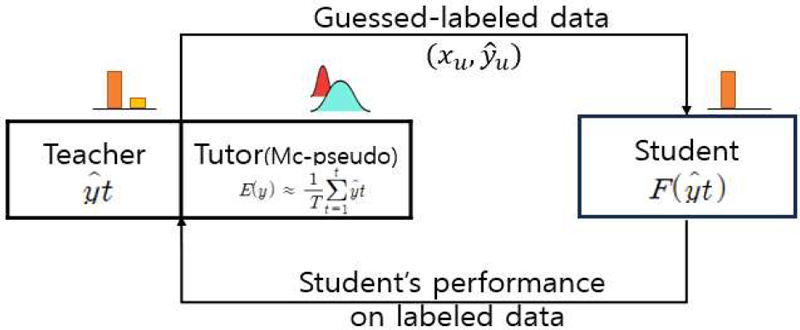

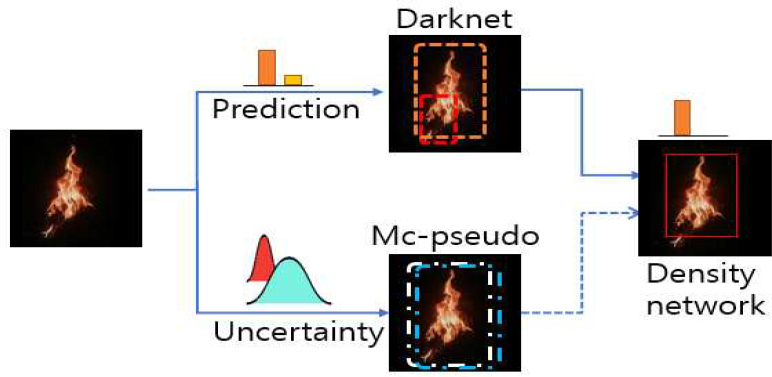

최근 데이터 생성을 목적으로 사용하는 딥러닝 방식은 대부분이 준지도 학습이다. 그리고 준지도 학습 방식 중 최근 논문 대부분은 이미지에 노이즈를 가하여 분류 값에 대해서 강인한 특성을 갖도록 설계되어 있다. 그러나 화재와 같이 데이터 수집이 제한되고, 모델의 신뢰도가 중요한 사항에서는 기존의 방식과 같이 노이즈에 강인한 방법으로는 인식률 향상과 데이터 증강에 분명 한계가 있다. 본 논문에서는 teacher(Convolution neural network)에서 예측(확률) 결과로 생성된 화재 가짜라벨 데이터에 오 라벨링이 존재한다고 가정을(실제도 존재함) 하고 student(가짜 라벨링) 전에 tutor(MC-pseudo)를 이용하여 화재 가짜라벨의 불확실성(분포)을 판단하고 가짜 라벨링 값보다 불확실성이 높으면 가짜 라벨링 판단을 보류하는 방식으로 화재 오 라벨링을 개선하기 위한 새로운 방식을 제안한다. 그림 1은 Mc-pseudo 라벨링을 활용한 자기 학습 기본 개념도를 그림으로 표시하였다. 는 추론 확률, E(y)는 추론 분포, F()는 최종 추론 결과, xu, 는 예측 데이터 정보이다.

Ⅱ. 관련 이론

2.1 자기 학습(Self-training)

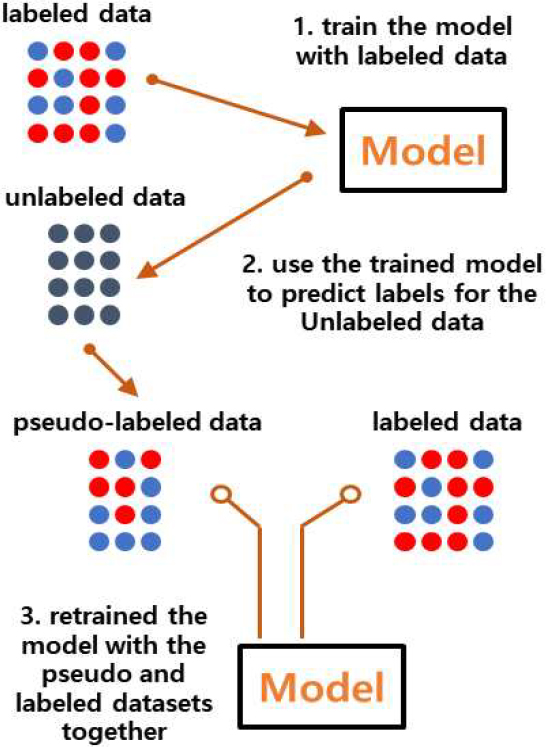

자기 학습이란 이름에서도 알 수 있듯 "스스로 학습"하는 방식 알고리즘이다. 자기 학습하는 방식은 바로 가짜라벨을 통해서다. 선 진행된 학습 모델을 통하여 라벨이 되어있지 않는 데이터에 대한 가짜라벨을 생성하고, 이를 GT(Ground Truth)처럼 생각하고 현재 모델을 학습시키는 것이다.

준지도 학습(SSL)의 한 방법이며, 실제로도 준지도 학습에서 주요 학습 방법으로 많이 사용되고 있다. 그러나 자기 학습의 단점은 초기 학습 데이터가 부정확할 경우 가짜 라벨링의 부정확으로 이어져 결국 잘못된 편향이 발생하여 전체 모델에게 악영향을 주게 되는 점이다. 그림 2가 대표적인 자기 학습 방식인 가짜라벨의 기본 개념도이다[4].

2.2 몬테카를로 방법

몬테카를로 방법(Monte Carlo method) 또는 MC(Monte Carlo) 드롭아웃은 반복된 무작위 추출(Repeated random sampling)을 이용하여 함수의 값을 수리적으로 근사하게 예측 값을 구하는 알고리즘이다. 이를 통해 불확실성(uncertainty)을 추정할 수 있다. 몬테카를로 드롭아웃은 베이지 룰의 한 방법이다. 다음 세 가지 확률로 베이지를 정의할 수 있다. 사후확률(Posterior(P(wi|x)))은 특징(x)가 주어졌을 때 특정 클래스에 속할 확률을 말하며, 가능도(Likelihood(P(xvertwi)))는 특징(x)가 어느 정도 분포로 되어 있는지의 정보를 말하며, 사전확률(Prior(P(wi)))은 특징(x)와 관계없이 각 클래스의 비율이 얼마나 되는지를 나타내는 값이다. 몬테카를로 드롭아웃의 궁극적 목적은 사후확률(Posterior(P(wi|x)))을 구하는 것이다.

기존의 딥러닝 모델들은 하나의 입력에 대해 하나의 출력 결과를 도출하는 방식이었다. 즉 점 추정 방식으로 우리가 사용하고 있는 딥러닝은 Softmax의 argmax(P(xvertwi))를 만족하는 하나의 가중치 포인트 wi을 찾는 문제이다. 반면 몬테카를로 방법은 P(wi|x), 즉 사후확률 그 자체를 구하는 것이다. 몬테카를로 드롭아웃은 하나의 입력에 대해 여러 번 출력을 얻고, 이 여러 출력의 분포를 구하는 것으로 볼 수 있다. 이 경우 출력의 분포에서 나오는 분산 값의 넓이를 불확실성이라 추정할 수 있다[5].

불확실성을 구하는 여러 방법 중에서 가장 많이 사용되는 방법이 몬테카를로 방법이다. 몬테카를로 드롭아웃에서는 필요에 따라 각 드롭아웃 층을 활성화한 후 모델을 학습한다. 그러나 기존의 드롭아웃과 달리, 추론 시에도 드롭아웃을 활성화해, 뉴럴 네트워크의 가중치를 샘플링하는 방식이다. 이를 통해 여러 번의 출력 값을 구한다. 이렇게 나온 출력 값들의 예측 분포를 사후확률에서 샘플링 된 분포의 결과를 보고, 불확실성의 분포를 계산할 수 있다[6]. 그림 3에는 몬테카를로 드롭아웃 방식에 대한 개념 이미지를 표현하였다.

2.3 Meta pseudo 라벨

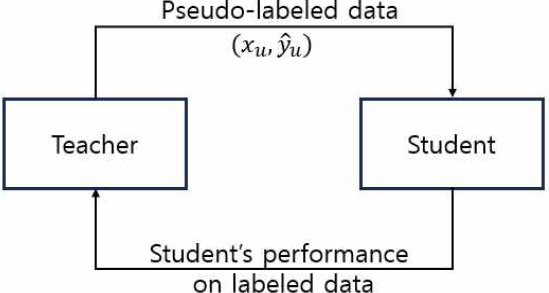

가짜라벨은 teacher, student로 한 쌍의 네트워크를 구성하고 있다. teacher는 unlabeled 데이터에 가짜라벨을 생성한다. 그 이후 가짜라벨이 할당된 데이터와 labeled 데이터를 합쳐 student를 학습시킨다. 이때 가짜라벨 데이터에 정규화를 위해 데이터 증강과 같은 방법이 사용된다. 그러나 가짜라벨은 이름에서 알 수 있듯 라벨이 정확하지 않기 때문에 student는 정확하지 않은 데이터로부터 학습이 되는 것과 같다. 그 결과 student는 teacher보다 매우 높은 성능을 가지기 힘들다.

Meta pseudo 라벨에서는 가짜라벨이 student에 어떤 영향을 끼치는 영향을 분석한다. 그 후 student로부터 정보를 받아 더 좋은 가짜라벨을 teacher가 생성하는 방법인 Meta pseudo 라벨라는 방법을 제안하였다[7]. 그림 4에는 Meta pseudo 라벨 동작원리를 표시하고 있다. 가짜라벨은 unlabeled 데이터로 부터 교차 엔트로피 손실을 최소화하는 방향으로 학습한다. 이것을 수식으로 표현하면 식 (1)과 같다.

| (1) |

T(xu;θT) : Prediction of teacher on unlabeld data

S(xu;θS) : Prediction of student on unlabeld data

S(xl;θS) : Prediction of student on labeled data

CE(q,p) : cross-entropy

student의 최적 파라메타 θSPL은 항상 가짜라벨인 T(xu;θT) 때문에 teacher의 파라미터 θT에 의존한다. Meta pseudo 라벨을 효과적으로 설명하기 위해 θSPL(θT)의 의존성을 알아야 한다. 그리고 Ll(θSPL(θT))는 θT의 함수이며, Ll(labeled 데이터 loss)를 θT의 관점에서 최적화하는 것은 식 (2)와 같이 표현할 수 있다.

| (2) |

식 (2)를 직관적으로 보면 labeled 데이터 모델로부터 얻은 student의 결과에 따라 teacher를 최적화함으로써 가짜라벨의 student의 성능도 높일 수 있다.

Ⅲ. 제안하는 방법

3.1 Mc-pseudo 라벨링을 활용한 자기 학습

최근 AI 딥러닝 모델에서 준지도 학습 방식은 Meta pseudo 라벨 논문 이후 teacher가 더 좋은 가짜라벨을 생성할 수 있도록, teacher가 지속해서 student network로부터 정보를 받아 파라미터를 조정하는 방식이다. 즉, student만 teacher를 통해서 배우는 것이 아니라, teacher도 student를 통해서 배움으로써 학습 파라미터를 최적화하는 방식이다. 그러나 이 모델 역시도 초기의 잘못된 파라미터가 가짜라벨에 영향을 주는 것을 막을 방법이 없다.

이를 근본적으로 개선하기 위해서는 초기 화재 labeled 데이터로 학습한 모델이 가짜 라벨링을 할 때 잘못된 라벨 데이터를 걸러내는 것 말고는 방법이 없다. 이것을 수작업으로 진행한다면 자기 학습 방식이라고 이름하지 않았을 것이다. 지금까지는 초기 바이어스까지 개선이 필요할 정도로 정확도가 높지 않았다면 현재는 초기 바이어스가 성능 향상에 결정적 역할을 할 시점이 도래했다.

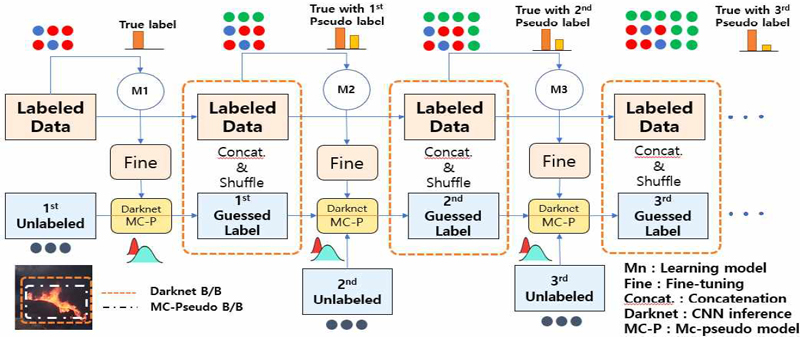

본 연구에서는 초기에 잘못된 바이어스가 파라미터에 미치는 영향을 최소화하기 위해 그림 1과 같이 기존 teacher(CNN: 모델추론) 외에 tutor(MC -dropout: 추론 안정성)를 추가하여 초기에 잘못된 바이어스 정보가 화재 데이터에 유입되는 것을 최소화하였다. 그림 5에는 Mc-pseudo 라벨링을 활용한 자기 학습 전체 개념도이다. CNN + MC-dropout:의 의미는 teacher(Darknet: 추론 확률)와 tutor(Mc-pseudo: 추론 분포)를 의미한다[8].

Darknet은 labeled 데이터를 이용하여 초기 학습을 진행하고 학습의 파라미터를 안정화하기 위하여 학습된 모델을 기반으로 아키텍처를 fine-tuning으로 업데이트하였다. 그리고 Darknet은 최적의 모델을 활용하여 1차 unlabeled 데이터에 가짜 라벨링을 진행한다. Darknet이 초기 진행한 화재 pseudo labeled 데이터는 데이터의 부족으로 충분히 잘못된 labeled 데이터가 있을 수 있다. 그때 Mc-pseudo labeling을 활용하여 Darknet이 표시한 라벨링의 불확실성 분포를 예측하고 불확실성이 높은 특정 라벨링에 대해서 정보를 Darknet에 전달하고, Darknet은 불확실성이 높은 라벨에 대해서는 라벨링을 보류 또는 변경하는 방식으로 1차 Guessed labeled 데이터를 student에 학습용으로 활용한다.

student(CNN: 모델 학습)는 labeled 데이터(5,565개)와 1차 Guessed labeled(labeled의 반) 데이터를 합쳐서 학습을 진행한다. 이때 생성된 모델을 활용하여 학습의 파라미터를 안정화하기 위하여 fine-tuning으로 업데이트한다. 그리고 이 데이터를 활용하여 2차 unlabeled 데이터(labeled의 반)를 초기와 동일하게 teacher(Darknet: 추론 확률)를 활용하여 가짜 라벨링을 진행하고, tutor(Mc-pseudo: 추론 분포)를 이용하여 Darknet이 표시한 BB(Bounding box) 라벨링의 불확실성 분포를 예측하고 불확실성이 높은 특정 라벨링에 대해서는 Darknet에서 라벨링을 보류하는 방식으로 학습의 정확도를 개선하는 방식이다. 그리고 loss가 안정될 때까지 반복적으로 teacher(Darknet: 추론 확률) → tutor(Mc-pseudo: 추론 분포) → student(CNN: 모델 학습) → teacher(Darknet: 추론 확률) → ··· 순으로 자기 학습을 진행한다.

3.2 BB(Bounding Box) 불확실성 판단

몬테카를로 드롭아웃의 가장 큰 단점은 사후확률(posterior)을 계산할 수 없는데 있다. 몬테카를로 드롭아웃은 신경망에서 순방향 학습 시, 네트워크를 드롭아웃 하여 딥러닝의 정규화 효과를 주는 방법이다. 기존에는 추론 시 드롭아웃을 사용하지 않았지만, 몬테카를로 드롭아웃에서는 추론 시에도 드롭아웃을 그대로 유지하여 여러 개의 추론 값을 만들어 내고 그 추론 값의 평균을 이용하여 사후확률인 P(wi|x)를 P(wi|x) ≈ P(wi)로 근사화를 유도하였다[9].

본 논문에서는 몬테카를로 드롭아웃 방식을 활용하여 불확실성의 분포를 계산하는 방법을 적용하였다. 학습이 증가할수록 초기에 잘못된 바이어스가 유입되는 것을 차단하기 위하여 tutor(Mc-pseudo: 추론 안정성 검증)를 통하여 지속적이고 중복적으로 사후확률인 P(wi|x)를 구하였다[10][11]. 그리고 tutor(Mc-pseudo)는 결정론적인 가중치를 가지지 않고, 가중치의 정규 분포로부터 labeled 데이터의 불확실성을 라벨마다 BB(Bounding Box)를 추론하는 방식을 사용했다. 좀 더 상세히 설명하면 Darknet에서 예측(확률) 결과로 생성된 가짜 라벨 데이터에서 BB의 IOU를 계산하고, Mc-pseudo 라벨링에서는 불확실성(분포)으로 생성된 화재 가짜 라벨 데이터의 IOU를 서로 비교하여 동일한 크기와 위치의 IOU에 대해서만 추론의 정확성을 비교 판단하였다. 그 후 Darknet과 Mc-pseudo 라벨링의 정확도를 비교하여 추론 판단을 보류하거나 변경하였다. 그림 6에는 Mc-pseudo 라벨링의 불확실성을 활용한 BB의 IOU 판단을 비교 추론하는 방법을 도식화했다.

Ⅳ. 실험 방법 및 결과

Mc-pseudo 라벨링 방식을 활용한 화재 데이터 자동 생성에 관한 연구 실험은 CPU: AMD Ryzen 7 3700X 8-Core Processor 3.6 GHz, GPU: NVIDIA GeForce RTX 8000, RAM 32GB 컴퓨터 환경에서 실험하였다[12]. 화재 데이터 세트는 AI-Hub 화재 데이터 세트 일부와 인터넷에서 화재 관련 동영상 및 이미지를 확보하여 진행했다[12]. 초기 데이터 세트는 표 1에 표시된 것과 같이 5,565개를 기준으로 했다. 그리고 초기 학습 시 loss, mIOU, mAP를 표 1에 표시하였다.

표 2에는 초기 labeled 데이터 로 학습한 분류(Classification) 정보를 표시하였다. 모두 4가지로 Fire, Smoke, Spark, Person으로 구분하여 학습을 진행했다. 수량(Q’ty)은 라벨이 완료된 이미지를 의미한다. 대부분의 이미지에 여러 분류 정보가 있어 중복 라벨이 상당이 포함되어 있다. 다만 화재와 연관이 없는 사람은 추론 결과에서 제외하였다.

4.1 실험 결과

초기 5,556개의 labeled 데이터를 기준 데이터로 활용하여 CNN(Darknet-53)으로 학습을 진행하였으며, 화재 데이터의 라벨링 정확도와 화재 인식률 확인을 위해 객체 검출용으로 Yolov4를 사용하였다. 그중 화재 데이터의 라벨링은 ADG(Auto data generation) 방식을[13] 활용하여 자동 라벨링이 생성되도록 하였다. 표 3에는 단계별로 사용된 unlabeled 데이터 수량, Mc-pseudo 라벨링 한 수량과 학습에 사용된 전체 이미지 수량을 표시하였다. unlabeled 데이터 수량 대비 Mc-pseudo 라벨링에서 수량이 적은 이유는 불확실성(분포)의 크기가 80%를 넘을 경우에만 라벨링의 IOU를 서로 비교하여 해당 라벨링만 추론 판단을 보류하거나 변경하므로 라벨링이 없는 이미지가 발생했다. 이 라벨링이 없는 이미지를 삭제하여 전체 수량에서 차이를 보인다.

표 4에는 단계별로 초기 정답 라벨 데이터를 활용하여 Mc-pseudo 라벨링 한 결과에 대해서 화재 데이터를 기준으로 5차에 걸쳐 인식률 변화 결과를 loss, mIOU, mAP 순으로 표기하였다. 그 결과 초기 대비 mAP@50 기준으로 23.55% 개선된 86.22%로 개선된 결과를 얻었다.

가중치 값이 확률로 존재하는 Darknet-53과는 달리 Mc-pseudo 라벨링은 분포로서 존재하므로 같은 이미지라 할지라도 매번 결과가 다르게 나온다. 이 분포의 넓이가 불확실성의 크기를 표현하는데 학습 데이터가 부족한 부분에서 불확실성이 커지는 것을 알 수 있다.

표 5에는 차수별로 Mc-pseudo 라벨링의 불확실성이 분포가 클 경우(80% 이상)에는 false로 판단하여 화재 라벨링을 보류한 횟수를 표시하였다. 실험 결과에서 알 수 있듯이 Mc-pseudo 라벨링의 불확실성은 초기에 증가하다 학습이 안정될수록 입력 대비 약 3.7% 정도로 안정되는 것을 볼 수 있다.

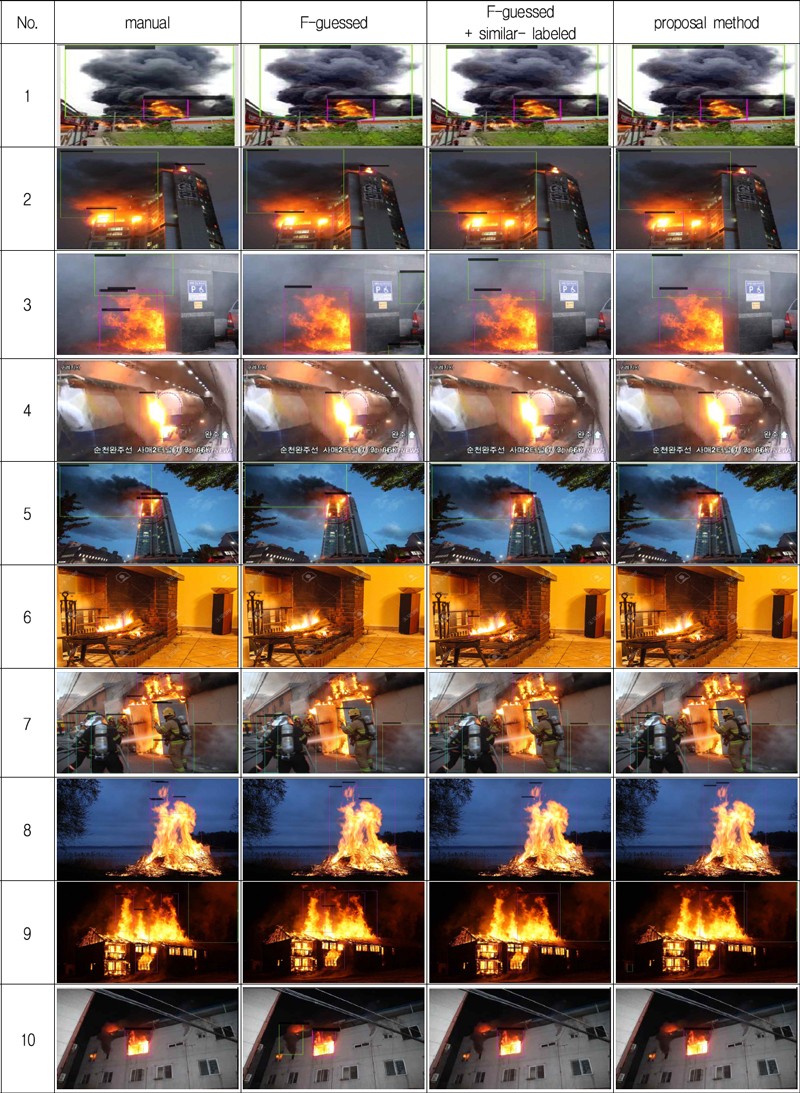

표 6에는 화재 데이터 증강을 목적으로 연구한 3가지 모델을 이용하여 비교 실험한 결과를 표시하였다. 수동(manual) 방식은 사람이 수작업으로 화재 데이터 36,749개를 손 라벨링 한 것을 의미하며, F-guessed 방식[12]은 단계적 자기 학습 방식을 활용한 자동 가짜 라벨링 방식이며, F-guessed + Similar-labeled 방식은 초기 데이터 부족 시 잘못된 바이어스가 파라미터에 영향을 주는 것을 방지하기 위하여 ROI 방식을 적용하여 특정 영역 내에 포함된 IOU는 모두 동일한 분류 가진다고 가정하여 화재 동영상에서 ROI(Region of Interest) 영역을 정하여 동일한 라벨링으로 처리하는 방식이다.

이렇게 하면 초기 바이어스가 안정되는 모습을 보이나 초기에 한번은 ROI를 정하는 불편함이 있다. 끝으로 이번에 제안하는 Mc-pseudo 라벨링 (F-guessed + MC-dropout) 방식은 자기 학습을 바로 하기 위해서는 teacher도 잘못된 정보로 학습할 수 있다는 가정하에 tutor를 통하여 한 번 더 불확실성을 검증한 후 학습하는 방식이다. 표 6에는 모델별로 실험한 결과를 수량, loss, mIOU, mAP@50 기준으로 표시하고 있다.

그 결과 수동(manual) 대비 loss는 2.38에서 1.22로 약 1.7% 개선이 되었으며 mIOU는 69.42에서 78.51로 9.09% 개선이 되었으며 mAP@50은 78.34에서 86.22로 약 8% 개선된 결과를 얻었다.

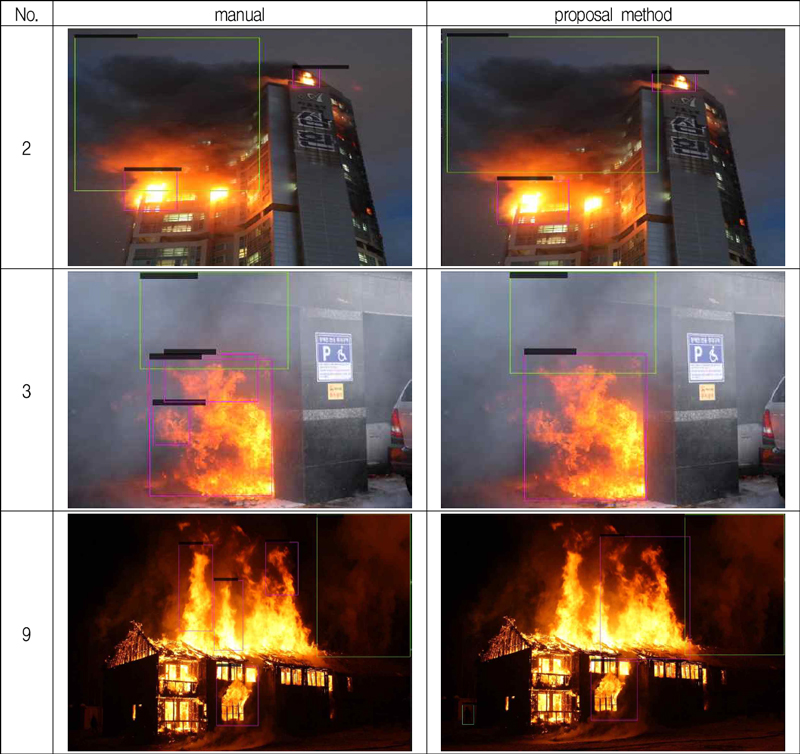

그림 7에는 수동으로 라벨링 한 이미지와 이번에 제안한 Mc-pseudo 라벨링 이미지 중 큰 변화가 있는 3개 이미지만 모아 상세히 설명한다. 이미지 2의 경우에는 수동 방식에서는 연기와 불의 경계면에서 연기를 표시하였으나 Mc-pseudo 라벨링에서는 불과 연기를 확실히 구분하여 경계를 표시하였다. 나머지 2개의 불은 동일하게 표시하였다. 이미지 3의 경우에는 연기는 둘 다 비슷하게 표현했으나 불의 경우에는 수동 방식에서는 동일한 불을 3가지로 구분하여 화재로 판단하였고, Mc-pseudo 라벨링에서는 한가지 BB로만 불을 표현하였다. 이유는 사람이 수동으로 라벨링 할 때 세부적으로 구분하였으니 Mc-pseudo 라벨링에서는 불확실한 BB에 대해서는 제외하여 불확실성이 낮은 경우만 BB를 유지하여 그렇게 된 것으로 판단된다.

이미지 9의 경우에는 수동 방식에서는 화재를 4가지로 구분하여 세부적으로 판단하였지만, Mc-pseudo 라벨링에서는 화재를 2가지로 구분하였고, 화재로 구분 가능한 이미지에 대해서는 확실한 경계를 구분하지 못하여 기존 수동 방식과 추론에서 차이를 보인다. 그러나 연기에 대해서는 둘 다 동일하게 바로 인식하고 있다. 3가지를 제외한 나머지 이미지에 대해서는 비슷한 결과를 보인다.

그림 8에는 표 6에서 실험한 4가지 (manual, F-guessed, F-guessed + Similar- labeled, Mc-pseudo 라벨링) 증강 방식에 따라 학습이 완료된 최종 가중치 값을 사용하여 화재 이미지별로 테스트한 결과를 모두 표시하였다.

Ⅴ. 결 론

본 논문에서는 화재 데이터 증강 시 초기에 적은 학습 데이터로 인하여 편향된 바이어스가 학습되고, 그 결과 가짜 라벨링이 편향된 라벨링으로 이어져 화재 오인식 및 데이터 증강에 나쁜 영향을 주므로 이를 개선하기 위하여 Mc-pseudo 라벨링 방식을 도입하였다, Mc-pseudo 라벨링 방식은 초기에 라벨링 한 가짜 라벨링에도 잘못된 정보로 학습할 수 있다고 가정을 하고 MC-dropout을 활용하여 라벨링의 불확실성 분포를 예측하고 불확실성이 높은 특정 라벨링에 대해서는 라벨링을 보류하거나 변경하는 방식으로 학습의 정확도를 개선하였다.

그 결과 약 4~7% 정도가 불확실성이 높다고 판단하여 라벨링을 제외하는 것으로 표 5에서와 같이 실험으로 확인되었다. 그리고 실제 사람이 손으로 라벨링 한 것과 비교 시 loss는 2.38에서 1.22로 약 1.7% 개선이 되었으며, mIOU는 69.42에서 78.51로 9.09% 개선이 되었다. 그리고 mAP@50은 78.34에서 86.22로 약 8% 개선된 결과를 얻었다. 현재 저자가 연구하고 있는 화재 데이터의 증강 및 인식률 개선 분야는 초기 학습데이터의 잘못된 편향을 줄이는 것이 매우 중요하므로 이를 개선하기 위한 추가 연구가 지속해서 필요해 보인다.

Acknowledgments

이 논문은 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No. RS-2023-00247045).

References

-

A. Kendall and Y. Gal, "What Uncertainties Do We Need in Bayesian Deep Learning for Computer Vision?", Computer Vision and Pattern Recognition (cs.CV), arXiv:1703.04977 [cs.CV], Oct. 2017.

[https://doi.org/10.48550/arXiv.1703.04977]

-

A. Jaiswal, A. R. Babu, M. Z. Zadeh, D. Banerjee, and F. Makedon, "A Survey on Contrastive Self-Supervised Learning", Technologies 2021, Vol. 9, No. 1, Oct. 2020.

[https://doi.org/10.3390/technologies9010002]

- C. Wei, J. Z. HaoChen, and T. Ma, "Understanding Deep Learning Algorithms that Leverage Unlabeled Data", The Stanford AI Lab Blog, Feb. 2022. https://ai.stanford.edu/blog/understanding-self-training, [accessed: Nov. 10, 2023]

- D.-H. Lee, "Pseudo-label: The simple and efficient semi-supervised learning method for deep neural networks", In ICMLW, Vol. 3, No. 2, pp. 896, 2013.

- C. M. Bishop and M. E. Tipping, "Bayesian Regression and Classification", Computer and Systems Sciences, Vol. 190, pp. 267-285, 2003.

- C. Blundell, J. Cornebise, K. Kavukcuoglu, and D. Wierstra, "Weight Uncertainty in Neural Networks", Proceedings of the 32nd International Conference on Machine Learning, Lille France, Vol. 37, pp. 1613-1622, Jul. 2015.

- H. Pham, Z.g Dai, Q. Xie, and Q. V. Le, "Meta Pseudo Labels", Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Nashville, TN, USA, pp. 11557-11568, Jun. 2021.

-

V. Mullachery, A. Khera, and A. Husain, "Bayesian Neural Networks", Machine Learning (cs.LG), arXiv:1801.07710[cs.LG], pp. 25-32, Oct. 2018.

[https://doi.org/10.48550/arXiv.1801.07710]

- Y. Gal and Z. Ghahramani, "Dropout as a Bayesian Approximation: Representing Model Uncertainty in Deep Learning", The 33rd International Conference on Machine Learning, New York NY USA, Vol. 48, pp. 1050-1059, Jun. 2016.

-

K. Brach, B. Sick, and O. Dürr, "Single Shot MC Dropout Approximation", Machine Learning (cs.LG), arXiv:2007.03293 [cs.LG], Jul. 2020.

[https://doi.org/10.48550/arXiv.2007.03293]

- Yarin Gal, "What My Deep Model Doesn't Know", Jul. 2015. https://www.cs.ox.ac.uk/people/yarin.gal/website/blog_3d801aa532c1ce.html, [accessed: Oct. 10, 2023]

-

J.-S. Kim and D.-S. Kang, "A Study on Automatic Data Generation and Object Recognition Rate Improvement using Heterogeneous Object Detection and Duplicate Labeling Method", The Journal of Korean Institute of Information Technology, Vol. 20, No. 5, pp. 21-29, May 2022.

[https://doi.org/10.14801/jkiit.2022.20.12.123]

-

J.-S. Kim and D.-S. Kang, "A Study on Fire Data Generation and Recognition Rate Improvement using F-guessed and Semi-supervised Learning", The Journal of Korean Institute of Information Technology, Vo. 20, No. 12, 123-134, Dec, 2022.

[https://doi.org/10.14801/jkiit.2022.20.12.123]

1991년 2월 : 부경대학교 전자공학과(공학사)

2020년 8월 : 동아대학교 전자공학과(공학석사)

2020년 9월 ~ 2023년 2월 : 동아대학교 전자공학과 박사수료

관심분야 : 영상처리, AI

1994년 5월 : Texas A&M 대학교 전자공학과(공학박사)

1995년 ~ 현재 : 동아대학교 전자공학과 교수

관심분야 : 영상처리, AI, 패턴인식